Les systèmes informatiques participent de plus en plus aux décisions de notre quotidien, notamment les intelligences artificielles (IA), ces systèmes qui permettent de prendre en charge des fonctions jusque-là propres aux humains. Mais comment peut-on leur faire confiance si l’on ignore leurs modalités de fonctionnement ? Et qu’en est-il quand ce système est amené à prendre des décisions qui peuvent mettre nos vies en jeu ?

Réglementer les IA

Véronique Steyer, maître de conférences au département management de l’innovation et entreprenariat (MIE) de l’École polytechnique, travaille depuis plusieurs années sur la question de l’explicabilité de l’IA. Selon elle, il est important de distinguer la notion d’« interprétabilité » – qui consiste à comprendre comment fonctionne un algorithme, pour pouvoir éventuellement améliorer sa robustesse et diagnostiquer ses failles – de la notion de « rendu de compte ». Cela revient à se demander : en cas de dégâts matériels ou corporels causés par une intelligence artificielle, quel est le degré de responsabilité de la personne ou de l’entreprise qui a conçu ou qui utilise cette IA ?

Or les outils d’explicabilité des IA, quand ils existent, sont généralement développés dans une logique d’interprétabilité, et non de rendu de compte. En clair, ils permettent d’observer ce qui se passe dans le système, sans forcément chercher à comprendre ce qui s’y passe, et quelles décisions sont prises en fonction de quels critères. Ils peuvent ainsi être de bons indicateurs d’un degré de performance de l’IA, sans pour autant assurer l’utilisateur de la pertinence des décisions prises.

Pour la chercheuse, il serait donc nécessaire d’encadrer d’un point de vue réglementaire ces IA. En France, le code de la santé publique stipule déjà que « les concepteurs d’un traitement algorithmique […] s’assurent de l’explicabilité de son fonctionnement pour les utilisateurs » (loi n° 2021–1017 du 2 août 2021). Avec ce texte, le législateur visait plus particulièrement les IA permettant de diagnostiquer certaines maladies, dont des cancers. Mais encore faut-il former les utilisateurs – en l’occurrence les professionnels de santé – non seulement à l’IA, mais aussi au fonctionnement et à l’interprétation des outils d’explication de l’IA… Comment savoir autrement si le diagnostic posé l’est en fonction des bons critères ?

Au niveau européen, un projet de règlement est en cours, qui devrait aboutir en 2023 à classer les IA selon différents niveaux de risque, et exiger en fonction de cela une certification qui garantirait un degré d’explicabilité plus ou moins fort. Mais qui doit mettre au point ces outils, comment éviter que les GAFA ne les contrôlent ? « On est loin d’avoir répondu à toutes ces questions épineuses, et nombre d’entreprises qui mettent au point des IA méconnaissent encore la notion d’explicabilité » constate Véronique Steyer.

Se libérer des tâches chronophages

Pendant ce temps, des IA de plus en plus performantes sont développées dans des secteurs d’activité de plus en plus divers ! Entrepreneuse dans le secteur de l’intelligence artificielle, Milie Taing a fondé la start-up Lili.ai en 2016 sur le campus de Polytechnique. Elle a d’abord passé huit ans comme chargée de projet, spécialisée en contrôle des coûts, chez SNC Lavalin, le leader canadien des grands projets. C’est là qu’elle a été amenée à retracer l’historique de plusieurs dossiers de chantiers importants qui avaient pris énormément de retard.

Pour documenter les réclamations, il fallait fouiller jusqu’à 18 ans de données très hétérogènes (échanges de mails, pièces jointes, comptes rendus de réunion, etc.) et repérer à quel moment s’étaient produites les erreurs expliquant le retard pris par ces chantiers. Mais impossible pour des humains d’analyser des données éparpillées sur des milliers de boîtes mails et des dizaines d’années ! Or, dans les grands projets de BTP, ce chaos documentaire peut entrainer de très lourdes pénalités, et parfois même conduire au dépôt de bilan. Milie Taing a donc eu l’idée de mettre au point, avec des data scientists et des développeurs, un logiciel d’intelligence artificielle dont le rôle est de faire de l’archéologie documentaire.

« Pour explorer le passé d’un projet, nos algorithmes ouvrent tous les documents concernant ce projet un par un. Puis ils en extraient toutes les phrases et les mots-clés, et les étiquettent automatiquement avec des hashtags, un peu à la façon de Twitter, explique Milie Taing. Ces hashtags permettent finalement de mener des recherches documentaires de façon efficace. Pour éviter les dérapages s’il s’agit d’un projet en cours, nous avons modélisé une centaine de problèmes récurrents, risquant de déboucher sur une réclamation, et de possibles pénalités. »

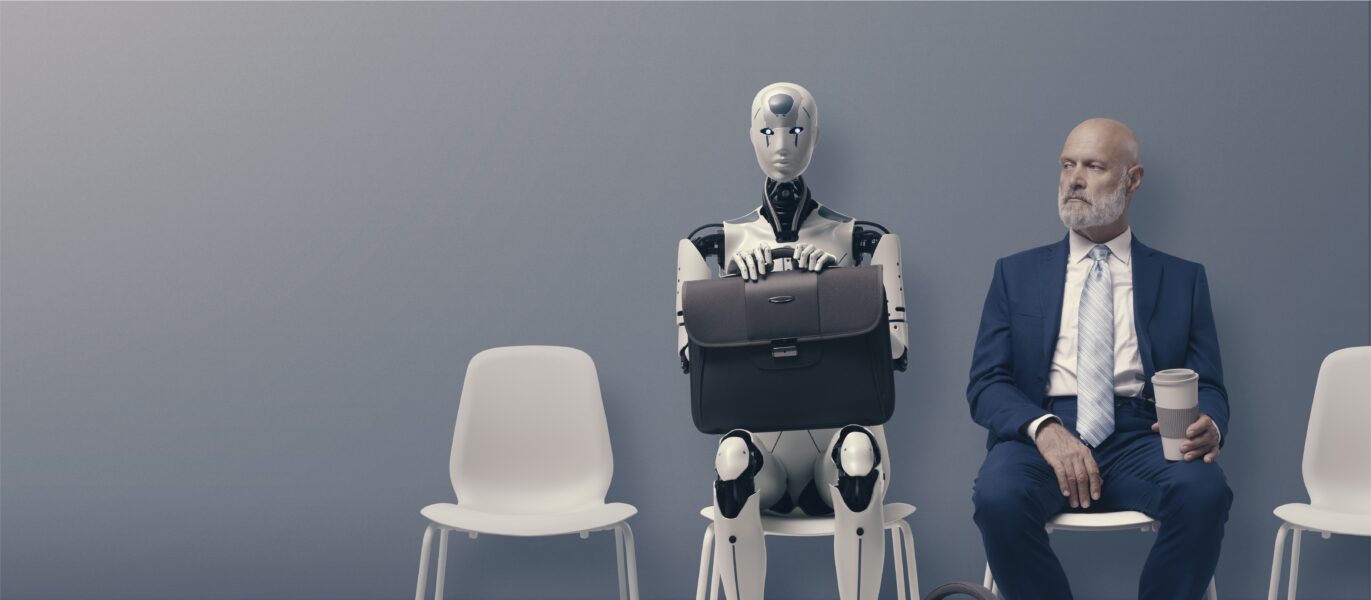

Le logiciel de la société Lili.ai est déjà utilisé par de grands comptes, comme la Société du grand Paris, EDF ou Orano (gestion des centrales nucléaires). Et selon Milie Taing, il ne menace pas l’emploi des chefs de projets. « L’IA dans ce cas est une aide au pilotage, qui permet d’identifier des dysfonctionnements avant qu’il ne soit trop tard, estime-t-elle. Elle vise à libérer l’humain des tâches chronophages et répétitives, lui permettant de se concentrer sur des travaux à plus forte valeur ajoutée ».

L’IA vise à libérer l’humain des tâches chronophages pour lui permettre de se concentrer sur des travaux à plus forte valeur ajoutée.

Mais cette IA ne risque-t-elle pas de pointer la responsabilité, voire la culpabilité de certaines personnes dans l’échec d’un projet ? « En fait, les salariés sont attachés à leurs projets et prêts à donner leurs e‑mails pour recouvrir les coûts et la marge qui aurait été perdue en cas de retard dans la réalisation du chantier. Si, juridiquement, les mails des personnels appartiennent à l’entreprise, nous avons inclus des fonctions très sophistiquées de filtrage sur notre logiciel qui donnent la main aux employés sur ce qu’ils acceptent ou pas d’exporter dans la solution Lili ».

Une belle place pour la France

Selon Milie Taing, la France a tout intérêt à investir dans ce type d’IA, car elle a une des meilleures expertises internationales dans la réalisation des très gros chantiers, et a donc accès à des quantités colossales de données. En revanche, elle sera moins performante que les Asiatiques, par exemple, sur d’autres applications, comme la reconnaissance faciale, qui de plus va à l’encontre d’une certaine éthique française.

« Toute technologie porte en elle un script, avec ce qu’elle nous permet ou non de faire, le rôle qu’elle donne à l’humain, les valeurs qu’elle porte aussi, souligne de son côté Véronique Steyer. Par exemple, dans les années 50, en Californie, on a construit une route menant à une plage, et pour que cette plage ne soit pas envahie par une population d’origine trop modeste, les ponts enjambant cette route ont été posés très bas, ce qui interdisait le passage des bus. Il me semble donc très important de comprendre non seulement comment fonctionne un système, mais aussi quels sont les choix de société inscrits dans un système d’IA de manière totalement tacite, qu’on ne voit pas ».

Actuellement, les IA qui se répandent le plus sont les chatbots, dont on ne peut pas dire qu’ils menacent l’espèce humaine. Mais en s’habituant à la performance de ces chatbots, on pourrait demain négliger de questionner les mécanismes et les objectifs d’IA plus sophistiquées.